大数据治理技术核心 元数据管理架构设计与数据处理服务一体化实践

随着企业数据规模的爆炸式增长,大数据治理已成为数字化转型的核心议题。高效的数据治理体系不仅关乎数据质量与安全,更直接影响数据价值的挖掘与业务决策的精准性。本文将围绕大数据治理的技术核心,重点探讨元数据管理的架构设计原则,并阐述其与数据处理服务的协同运作机制,为企业构建一体化数据治理平台提供参考。

一、大数据治理的技术核心:以元数据为基石

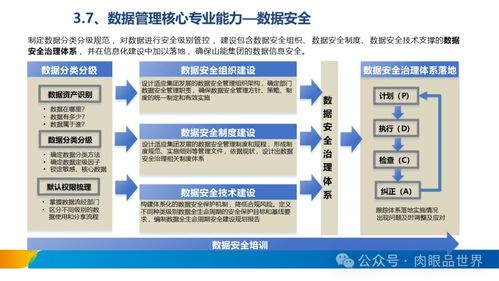

大数据治理是一个系统性工程,其技术核心在于实现对海量、多源、异构数据的有效管控。这包括数据标准管理、数据质量管理、数据安全管理、数据生命周期管理等多个维度。而贯穿所有治理环节的“灵魂”与“纽带”,正是元数据(Metadata)。

元数据是“描述数据的数据”,它记录了数据的业务含义、技术属性、来源、血缘关系、变更历史及使用情况等关键信息。完善的元数据管理能够:

- 提升数据可发现性与理解度:帮助用户快速定位和理解所需数据。

- 保障数据质量与一致性:通过跟踪数据血缘,定位数据问题根源。

- 加强数据安全与合规:清晰界定数据的敏感级别和访问权限。

- 支持数据资产化:将数据作为可管理、可评估的企业资产。

因此,一个健壮、灵活的元数据管理架构是构建高效数据治理体系的先决条件。

二、元数据管理架构设计的关键要素

一个现代化的元数据管理架构不应是孤立的系统,而应是融入数据技术栈、支撑全链路治理的“中枢神经系统”。其设计需遵循以下原则:

1. 分层解耦与模块化设计

架构通常分为采集层、存储层、服务层与应用层。

- 采集层:负责从各类数据源(如Hive、MySQL、Kafka、数据仓库、BI工具、调度系统等)自动或半自动地采集技术元数据、业务元数据与操作元数据。需支持灵活的适配器与接口。

- 存储层:采用适合存储关联关系的数据库,如图数据库(Neo4j, JanusGraph)存储数据血缘与资产关系,辅以关系型数据库或搜索引擎(Elasticsearch)存储属性详情,实现高效查询与关系追溯。

- 服务层:提供统一的元数据API,包括资产检索、血缘查询、影响分析、变更通知等核心服务,供上层应用调用。

- 应用层:基于服务层构建的数据目录、血缘地图、资产检索门户、治理工作台等,面向最终用户。

2. 自动化与主动采集

减少人工维护,通过监听数据平台日志、解析SQL脚本、对接调度工具等方式,实现元数据的自动发现、血缘关系的自动解析与变更的主动同步。

3. 血缘分析与影响分析能力

架构必须支持端到端的数据血缘(Data Lineage)追踪,即从数据产生到最终消费的全链路可视化。这能精准定位数据问题的影响范围(影响分析)或追溯报表指标的来源(溯源分析),是数据可信度的关键保障。

4. 可扩展性与开放性

架构需预留接口,方便接入新的数据源类型和工具,并能与现有的数据安全、质量、开发平台无缝集成。

三、与数据处理服务的深度协同

元数据管理并非终点,其价值在与数据处理服务的协同中得以倍增。数据处理服务包括数据集成、开发、质量检测、运维等。

1. 赋能数据开发与集成

在数据开发平台中,开发者可实时查询元数据,了解表结构、样本数据、血缘由来的关系,避免重复建表与错误引用。数据集成任务可根据元数据自动映射源端与目标端字段,提升开发效率。

2. 驱动数据质量管理

数据质量规则(如唯一性、有效性校验)可以基于元数据(如字段类型、业务定义)进行配置和关联。当质量检查出问题时,可通过血缘关系快速定位到上游出错的任务或数据源,实现闭环治理。

3. 支撑数据运维与成本优化

通过分析元数据中的表访问热度、产出任务、存储大小等信息,可以智能识别出长期无人访问的“冷数据”或计算冗余的任务,为数据归档、资源优化提供决策依据,有效降低存储与计算成本。

4. 增强数据服务与消费体验

对外提供的数据API服务或数据市场,可以附上丰富的元数据(如API文档、版本、数据来源说明、SLA),让数据消费者用得明白、用得放心。

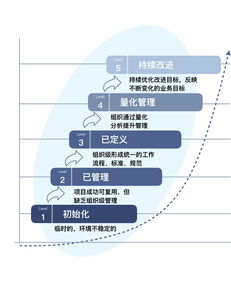

四、与展望

大数据治理的成功,依赖于将元数据管理架构作为核心引擎,并与数据处理服务流程深度耦合。未来的趋势将是构建“主动型”、“智能化”的元数据管理:利用机器学习技术自动打标、推荐关联关系、预测数据质量风险,并进一步与DataOps、AIOps理念结合,实现数据治理的自适应与自优化。企业应从顶层设计出发,规划好元数据战略,选择或构建贴合自身技术栈的架构,让数据真正成为驱动业务创新的核心资产。

如若转载,请注明出处:http://www.ftvhtj.com/product/48.html

更新时间:2026-02-27 00:15:42