HCIP学习笔记 数据库服务规划之数据处理服务详解

在HCIP(华为认证ICT高级工程师)数据库服务规划的学习中,数据处理服务是确保数据价值得以有效释放的核心环节。它不仅仅是简单的数据增删改查,而是一个涵盖数据采集、转换、加工、分析和应用的完整服务体系。本文将围绕数据处理服务的核心概念、关键技术和规划要点进行梳理。

一、数据处理服务的内涵与定位

数据处理服务位于数据库整体架构的“应用层”与“存储层”之间,其核心目标是将原始数据转化为可供业务直接使用的信息、知识或服务。在云数据库或分布式数据库体系中,它通常以一系列服务化、组件化的形式提供,例如:

- 数据集成服务:负责从异构数据源(如业务数据库、日志文件、IoT设备)实时或批量抽取数据。

- 数据转换与清洗服务(ETL/ELT):对数据进行标准化、去重、补全、脱敏等操作,保障数据质量。

- 数据计算与分析服务:提供批处理(如Spark)、流处理(如Flink)、交互式查询(如Presto)等计算引擎,执行复杂的业务逻辑与数据分析。

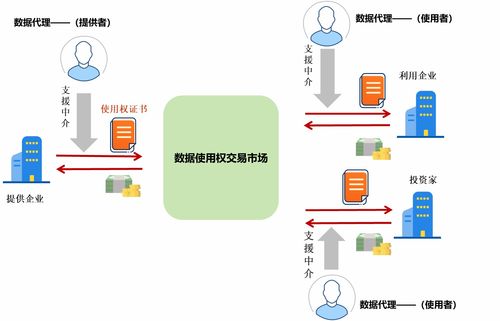

- 数据服务化(Data API):将处理后的数据以API接口的形式安全、高效地暴露给前端应用,实现数据与应用的解耦。

二、关键技术组件与架构

规划数据处理服务时,需重点考量以下技术组件及其选型:

- 计算引擎选择:

- 批处理场景:适用于T+1报表、历史数据挖掘。需关注引擎的吞吐量、资源利用率和与存储系统的兼容性(如Hive on HDFS)。

- 流处理场景:适用于实时监控、实时推荐。需关注引擎的延迟、Exactly-Once语义保障及状态管理能力。

- 混合处理(Lambda/Kappa架构):结合批流优势,满足复杂业务需求。

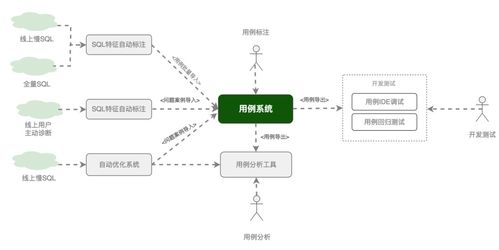

- 数据流水线编排:采用如Apache Airflow、DolphinScheduler等工具,实现数据处理任务的可视化编排、调度与监控,确保任务依赖关系正确、执行可控。

- 数据质量与治理:在数据处理各环节嵌入质量校验规则(如完整性、一致性检查),并建立数据血缘追踪,确保数据处理过程可审计、问题可溯源。

三、核心规划要点与实践建议

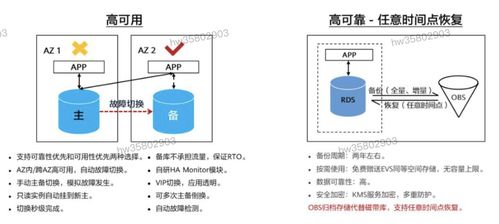

- 明确处理目标与SLA:首先界定数据处理是服务于实时决策、离线报表还是数据科学探索。不同的目标决定了不同的技术栈与资源投入。必须明确数据处理的延迟、准确性等SLA(服务等级协议)要求。

- 设计可扩展的流水线:数据处理逻辑会随业务快速变化。规划时应采用模块化、低耦合的设计,便于单个环节的独立更新与扩展。计算与存储资源应能弹性伸缩,以应对数据量或计算压力的波动。

- 保障数据安全与合规:在数据处理过程中,尤其是涉及敏感信息时,必须规划数据脱敏、加密传输与存储、权限精细管控等措施。确保符合GDPR等数据隐私法规要求。

- 监控、运维与成本优化:建立完整的监控指标体系,涵盖任务执行状态、数据处理延迟、资源利用率、数据质量波动等。通过监控及时发现故障与性能瓶颈。对计算资源进行精细化管理(如自动启停、选择Spot实例),优化运营成本。

四、

数据处理服务是连接数据存储与业务价值的桥梁。在HCIP的视角下,规划者需要具备全局思维,不仅要精通各类计算引擎的技术特性,更要深刻理解业务需求,设计出高可靠、高效率、易维护且成本可控的数据处理体系。一个优秀的数据处理服务规划,能够使数据资产灵活、稳定地驱动业务创新与智能决策。

(注:本笔记基于华为云数据库及相关开源技术生态的最佳实践进行归纳,具体实现需结合实际项目需求与技术选型进行调整。)

如若转载,请注明出处:http://www.ftvhtj.com/product/66.html

更新时间:2026-02-25 21:34:08